总体步骤

1.下载Ollama并安装运行DeepSeek

2.下载Chatbox并配置为本地DeepSeek

3.开启DeepSeek本地交互(无需联网)

一、下载Ollama并安装运行DeepSeek

1、从Ollama官方网站下载Ollama:

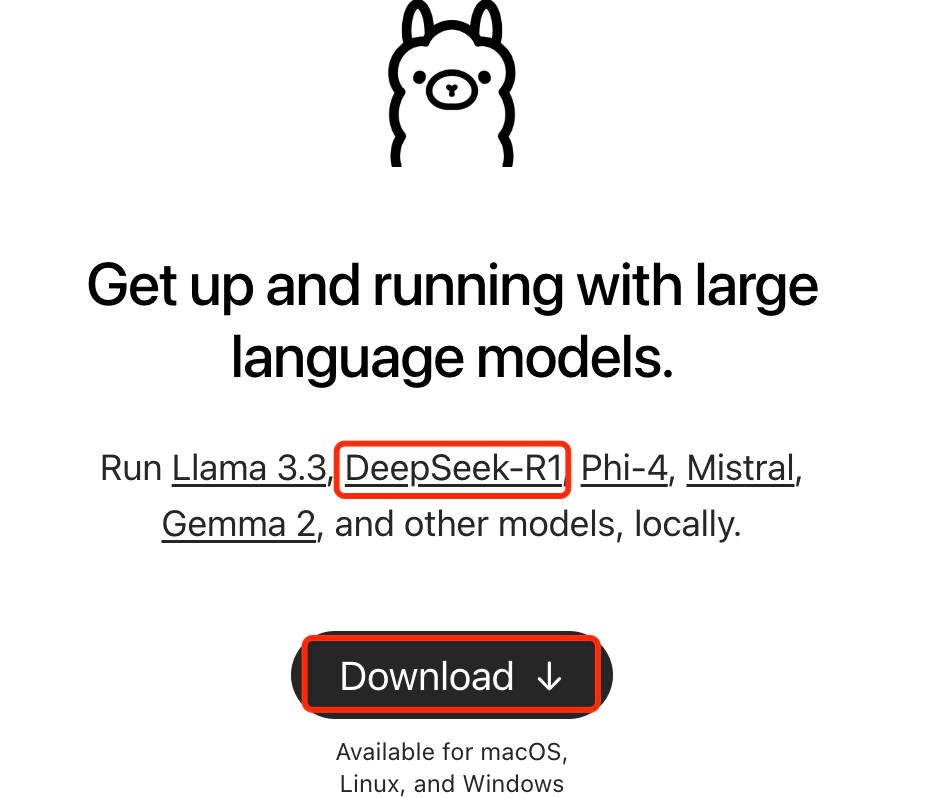

进入Ollama官方网站后,可以看到Ollama已经支持DeepSeek-R1的部署:

2、点击DeepSeek-R1的链接可以看到有关deepseek-r1的详细介绍:

目前deepseek-r1模型大小提供了7个选择:1.5b、7b、8b、14b、32b、70b、671b。

如果你的Mac内存配置较低(8G内存),建议选择最小的1.5b模型,如果是16G内存,建议选择7B或8B模型,模型选择原则:内存>模型标号

通常模型大小(参数量)越大,模型的理解和生成能力越强,但也会消耗更多的计算资源。至于671B的完全体就不要想了,mac没那么大内存可以跑起来

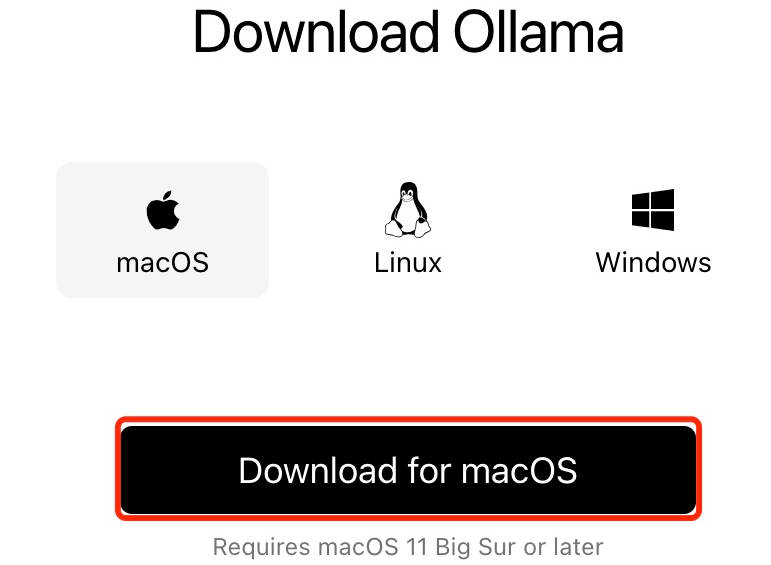

3、点击Download按钮下载符合自己平台的Ollama:

这里选择macOS,点击下载。

下载文件大小不到200M,文件名为:Ollama-darwin.zip。

4、解压后打开Ollama应用程序,点击next,点击Install 安装ollama。

5、按照提示,打开终端,使用 Command + Space 快捷键调用 terminal:

在终端窗口运行下面命令:

1 | ollama run deepseek-r1:8b |

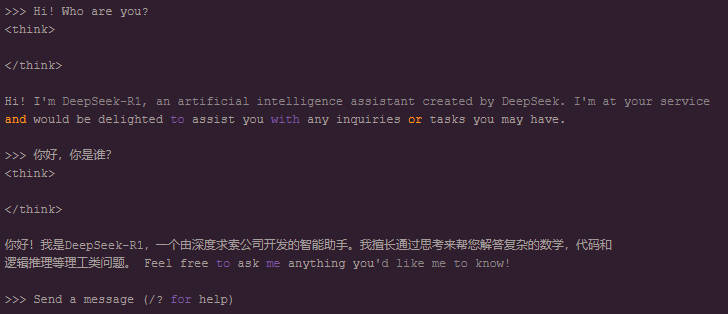

6、下载完毕的话,在终端中就直接可以和DeepSeek对话了:

二、下载Chatbox并配置为本地DeepSeek

1、打开Chatbox官方网站:https://chatboxai.app/en

2、下载的Chatbox-1.9.7.dmg,大小100M多点,点击安装,启动:

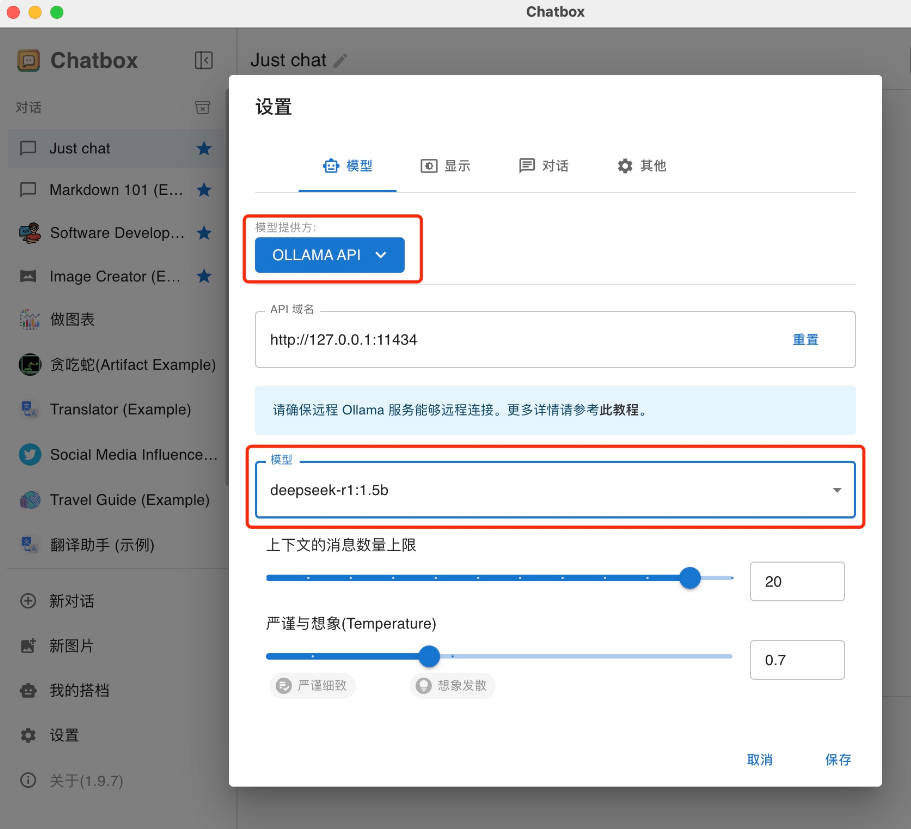

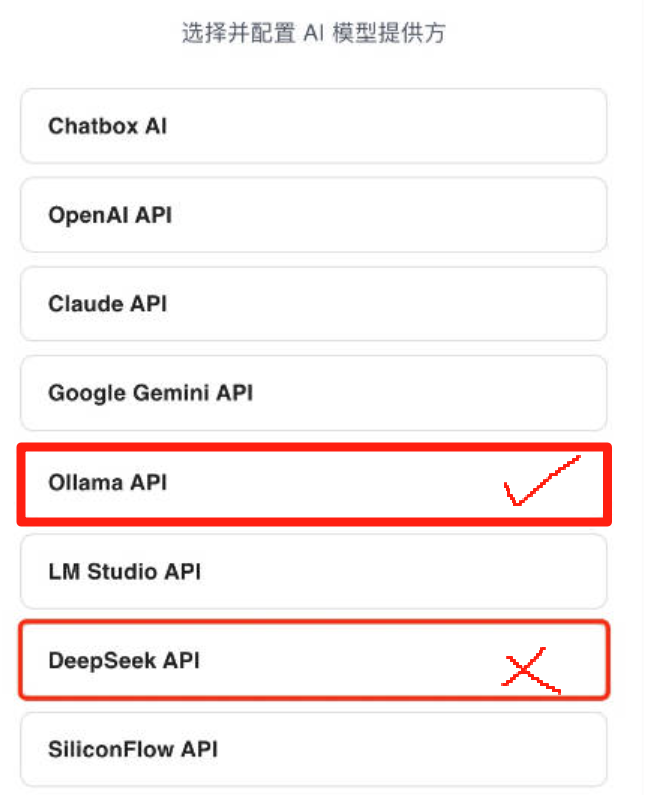

3、这里不能选择DeepSeek API,若选择这个你就找不到你本地的DeepSeek模型。

正确的应该选择OLLAMA API,然后就可以看到我们上一步安装好的deepseek-r1:8b或其他参数的模型